Los pasados 26 y 27 de Octubre de 2012 Microsoft en colaboración con la universidad de Nankai y la universidad de Tianjin organizó una nueva edición del «Asia Faculty Summit» celebrado en Tianjin.

Los pasados 26 y 27 de Octubre de 2012 Microsoft en colaboración con la universidad de Nankai y la universidad de Tianjin organizó una nueva edición del «Asia Faculty Summit» celebrado en Tianjin.

En esta nueva cumbre se dieron cita educadores, investigadores académicos e investigadores de Microsoft para debatir temas relacionados con la «Promoción de la Investigación y Educación».

Uno de los ponentes que más llamó, favorablemente, la atención fue Rick Rashid, Oficial en Jefe de Investigación de Microsoft. Rick comenzó su ponencia haciendo un poco de historia sobre como Microsoft ha ido siendo testigo presencial de la evolución del speech-to-speech, abrió la presentación haciendo un poco de historia sobre cómo su compañía ha ido asistiendo en la evolución de la tecnología speech-to-speech, o como reconocer el habla y traducirla instantáneamente a otro idioma.

Como argumentó Rick Rashind hasta hace relativamente poco tiempo los sistemas de reconocimiento de voz tenían un margen de error de entre el 20% y el 25% hasta que Microsoft descubrió la técnica Deep Neural Networks.

Esta nueva técnica desarrollada por Microsoft consiste en que los sistemas de reconocimiento de voz puedan predecir basándose en patrones de conducta cerebral con la consiguiente menor tasa de errores y realizando su trabajo mucho más rápido.

Gracias a este nuevo sistema Microsoft consiguió que solo 1 palabra entre 7 u 8 estuviera mal interpretada y/o traducida, un 30% menos de error que los sistemas anteriores.

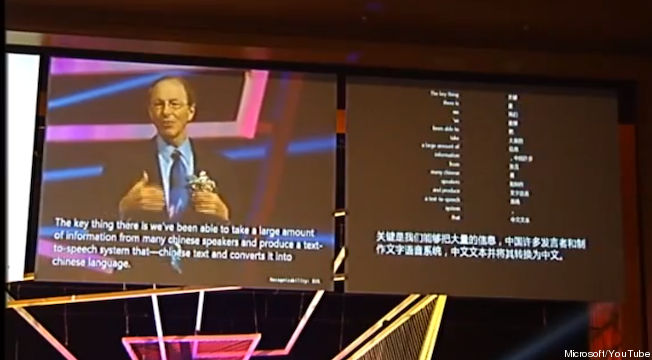

Como no podía ser de otra forma, estos sistemas hay que verlos para creerlos, mientras Rick Rashid daba su ponencia automáticamente el sistema reconociendo su voz y subtitulando la ponencia en la pantalla gigante con una eficiencia prácticamente absoluta.

Pero esto no fue todo, ya que cuando Rashid inició la presentación de la nueva tecnología de traducción instantánea también lo hizo en la práctica mostrándose los tres pasos de la traducción instantánea; reconocimiento de la voz y convertirla a texto, buscar el equivalente en chino de las dos primeras palabras de la frase y por último procesar y reordenar las palabras para que tuvieran sentido en chino. Aunque con algunos errores, como era de esperar, la precisión de la traducción fueron espectaculares. A mayores por medio de un sintetizador se escuchaba su voz hablando en chino.

[youtube_sc url=»http://youtu.be/Nu-nlQqFCKg» theme=»light»]

¿ Tendremos que esperar hasta el siglo 22 para poder utilizar esta nueva tecnología ?

EasyInternationalization ya estudia, a través de su Departamento de I+D, como poder incorporar este tipo de tecnologías a su sistema SAT.